جدول محتوا

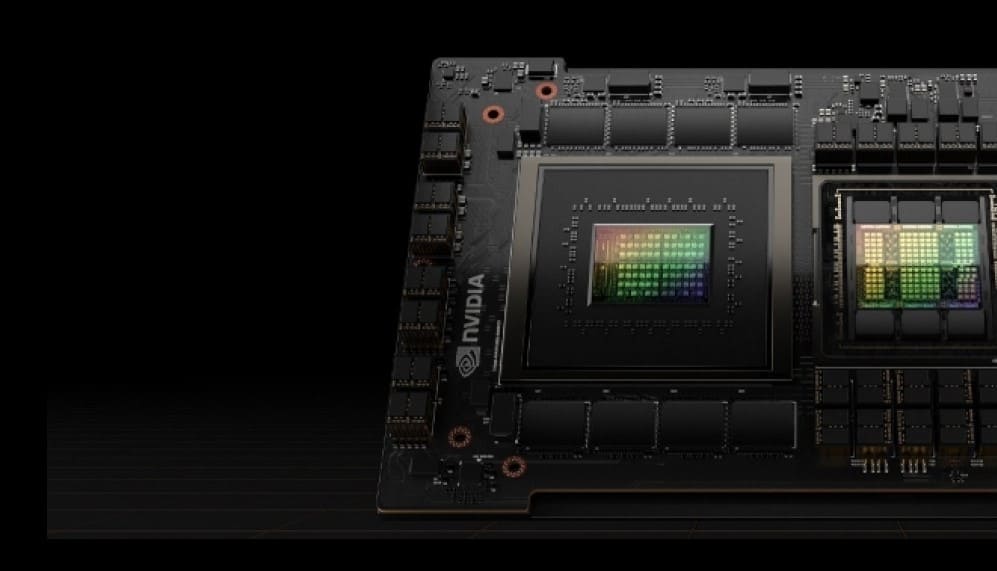

معماری NVIDIA GH200 Grace Hopper عملکرد پیشگامانه NVIDIA Hopper GPI-J را با تطبیق پذیری CPU NVIDIA Grace TM، متصل به پهنای باند بالا و حافظه منسجم NVIDIA NVLink Chip-2-Chip interconnect سوپرچیپ و پشتیبانی از سیستم سوئیچ NVIDIA NVLink جدید ارائه می دهد و یکی از موارد استفاده این سوپرتراشه در سرور HP مخصوص هوش مصنوعی مانند سرور HPE DL380a GEN12 میباشد.

NVIDIA NVLink-C2C حافظه منسجم، پهنای باند بالا و اتصال کم تاخیر انویدیا برای سوپرتراشه ها است. این قلب سوپرچیپ گریس هاپر است و پهنای باند کل تا 900 گیگابایت بر ثانیه را ارائه می دهد. این پهنای باند 7 برابر بیشتر از X 16 خط PCIe Gen5 است که معمولاً در سیستمهای شتابدار استفاده میشود.

هماهنگی حافظه NVLink-C2C بهره وری، عملکرد و میزان حافظه قابل دسترسی GPU سرور را افزایش می دهد. رشته های CPU و GPI-J اکنون می توانند به طور همزمان و شفاف به حافظه مقیم CPU و GPI-J دسترسی داشته باشند و به توسعه دهندگان این امکان را می دهد که به جای مدیریت صریح حافظه، روی الگوریتم ها تمرکز کنند.

نمای کلی گریس هاپر NVIDIA GH200

NVIDIA Grace CPU اولین CPU مرکز داده NVIDIA است و از ابتدا برای ایجاد سوپرتراشه های HPC و Al ساخته شده است. CPU NVIDIA Grace از 72 هسته CPU Arm Neoverse V2 برای ارائه عملکرد پیشرو در هر رشته استفاده می کند، در حالی که بازده انرژی بالاتری نسبت به CPU های سنتی ارائه می دهد. حداکثر 480 گیگابایت حافظه LPDDR5X با حداکثر 500 گیگابایت بر ثانیه پهنای باند حافظه در هر CPU، تعادل بهینه بین ظرفیت حافظه، بهره وری انرژی و عملکرد را فراهم می کند.

NVIDIA Hopper نسل نهم مرکز داده NVIDIA GPI-J است و برای ارائه بهبودهای مرتبهای برای کاربردهای Al و HPC در مقیاس بزرگ در مقایسه با نسلهای قبلی NVIDIA Ampere GPI-J طراحی شده است.

پلتفرم های NVIDIA GH200

سوپرتراشه GH200 Grace Hopper اساس بسیاری از طراحیهای سرور مختلف از جمله سرور HP را تشکیل میدهد که نیازهای مختلف در یادگیری ماشین و HPC را برآورده میکنند. انویدیا دو پلتفرم توسعه داده است که نیازهای متنوع مشتریان را برطرف می کند.

NVIDIA (MG)

با GH200 برای کاهش مقیاس راهحلهای شتابدهی اما نه فقط محدود به یادگیری ماشین سنتی (ML)، Al، تجزیه و تحلیل دادهها، پایگاههای داده شتابدار، و بارهای کاری HPC ایدهآل است. با حداکثر 624 گیگابایت حافظه سریع، یک واحد Node می تواند بارهای کاری مختلفی را اجرا کند و هنگامی که با راه حل های شبکه NVIDIA Connect-X7)، Spectrum-X، و BlueField-3 DPU) ترکیب می شود، مدیریت و استقرار این پلت فرم آسان است و از معماری سنتی شبکه های خوشه ای HPC/AI استفاده می کند.

NVIDIA GH200 NVL32

تمام رشتههای GPI-J در دامنه متصل به NVLink را قادر میسازد تا حداکثر 19.5 ترابایت حافظه با پهنای باند کل تا 900 گیگابایت بر ثانیه در هر سوپرتراشه و حداکثر 14.4 ترابایت بر ثانیه پهنای باند دوبخشی GPI-3 را آدرس دهی کنند. سیستم متصل J NVLink این پلتفرم را برای مقیاسبندی قوی در بزرگترین و چالشبرانگیزترین تمرینات آلی و بارهای کاری HPC در جهان ایدهآل میکند.

معماری NVIDIA GH200

ویژگیهای اصلی معماری NVIDIA GH200 شامل: NVLink-C2C، سیستم سوئیچ NVLink، حافظه پیشرفته GPI-J (ECM) و قابلیتهای محاسباتی انعطافپذیر سوپرتراشه است که در ادامه به توضیح آن ها می پردازیم.

NVLink-C2C

اتصال NVLink Chip-2-Chip (C2C) یک اتصال مستقیم با پهنای باند بالا بین CPU Grace و Hopper GPI-J برای ایجاد Superchip Grace Hopper، که برای شتاب دادن به برنامه های Al و HPC طراحی شده است، فراهم می کند. با 900 گیگابایت بر ثانیه پهنای باند دو طرفه، NVLink-C2C 7 برابر پهنای باند 16x پیوندهای PCIe Gen را با تأخیر کمتر ارائه می دهد. NVLink-C2C همچنین تنها از 1.3 پیکوژول در هر بیت انتقال داده شده استفاده می کند که بیش از 5 برابر انرژی کمتری نسبت به PCIe Gen 5 دارد.

علاوه بر این NVLink-C2C یک اتصال حافظه منسجم با پشتیبانی سخت افزاری بومی برای عملیات اتمی در سراسر سیستم است. این کار باعث بهبود عملکرد دسترسیهای حافظه به حافظه غیرمحلی، مانند رشتههای CPU و GPI-J که به حافظه ساکن در دستگاه دیگر دسترسی دارند، میشود. انسجام سختافزاری همچنین عملکرد اولیههای همگامسازی را بهبود میبخشد، زمان انتظار GPI-J یا CPU روی یکدیگر را کاهش میدهد و استفاده کلی از سیستم را افزایش میدهد. در نهایت انسجام سختافزار همچنین توسعه برنامههای محاسباتی ناهمگن را با استفاده از زبانها و چارچوبهای برنامهنویسی محبوب ساده میکند.

سیستم سوئیچ NVLink در GH200 NVL32

NVIDIA NVLink Switch System فناوری نسل چهارم NVIDIA NVLink را با نسل سوم NVIDIA NVSwitch ترکیب می کند. یک سطح از تراشه های NVSwitch موجود در سینی های سوئیچ NVLink تا 32 سوپرتراشه Grace Hopper را به هم متصل می کند و ارتباطات همزمان با پهنای باند کامل را بین هر یک از 32 سوپرتراشه Grace Hopper با اتصالات NVLink 900 گیگابایت بر ثانیه امکان پذیر می کند.

نسل چهارم NVIDIA NVLink رشتههای GPIJ را قادر میسازد تا حداکثر 19.5 ترابایت حافظه ارائهشده توسط تمامی سوپرتراشههای شبکه NVLink را با استفاده از عملیاتهای معمول حافظه، اتمی و انتقال انبوه آدرس دهی کنند. کتابخانه های ارتباطی مانند MPI، NCCL، یا NVSHMEM به طور شفاف از سیستم سوئیچ NVLink در صورت موجود بودن استفاده می کنند.

سیستم سوئیچ NVLink NVIDIA هر سوپرتراشه Grace Hopper را با پهنای باند 900 گیگابایت بر ثانیه به شبکه متصل می کند. یعنی یک جفت سوپرتراشه Grace Hopper داده ها را تا 900 گیگابایت بر ثانیه مبادله می کند. با حداکثر 32 سوپرچیپ گریس هاپر، شبکه تا 14.4 ترابایت بر ثانیه پهنای باند همه جانبه را ارائه می دهد. این پهنای باند همه جانبه InfiniBand NDR400 است.

مدل برنامه نویسی NVIDIA GH200

پلتفرمهای ناهمگن سنتی با شتابدهندههای متصل به PCIe از کاربران میخواهند از یک مدل برنامهنویسی پیچیده پیروی کنند که شامل مدیریت دستی تخصیص حافظه دستگاه و انتقال داده به و از میزبان است.

NVIDIA GH200 یک پلتفرم ناهمگن است که برنامهنویسی آن آسان است و انویدیا متعهد شده است که مستقل از زبان برنامهنویسی انتخابی آنها، آن را برای همه توسعهدهندگان در دسترس قرار دهد. هم GH200 و هم پلتفرم به گونهای ساخته شدهاند که توسعهدهندگان را قادر میسازند زبان مناسب را برای کار مورد نظر انتخاب کنند، و NVIDIA libNVVM API به توسعهدهندگان این امکان را میدهد تا زبان برنامهنویسی دلخواه خود را با همان سطح کیفیت تولید کد و بهینهسازیها به پلتفرم CUDA بیاورند.

زبانهای ارائه شده توسط NVIDIA برای پلتفرم CUDA شامل زبانهای استاندارد تسریعشده زیر است:

- ISO Fortran

- پایتون

و مدل های برنامه نویسی مبتنی بر دستورالعمل:

- OpenACC

- OpenMP

- CUDA Fortran

عملکرد و سرعت با پردازنده گرافیکی Hopper H100

GPU H100 Tensor Core نسل نهم پردازنده گرافیکی مرکز داده انویدیا است و جهش عملکردی مرتبهای را برای هوش مصنوعی و HPC در مقیاس بزرگ نسبت به GPU نسل قبلی NVIDIA A100 Tensor Core ارائه میکند. NVIDIA H100 مبتنی بر معماری جدید پردازنده گرافیکی Hopper دارای چندین نوآوری است:

- هستههای Tensor نسل چهارم جدید، محاسبات ماتریسی را سریعتر از همیشه در مجموعهای وسیعتر از وظایف هوش مصنوعی و HPC انجام میدهند.

- موتور ترانسفورماتور جدید H100 را قادر میسازد تا 9 برابر سریعتر آموزش هوش مصنوعی و تا 30 برابر استنتاج هوش مصنوعی سریعتر را در مقایسه با نسل قبلی GPU ارائه دهد.

- Secure Multi-Instance GPU (MIG) GPU را به نمونه های ایزوله و با اندازه مناسب تقسیم می کند تا کیفیت سرویس (QoS) را برای حجم کاری کوچکتر به حداکثر برساند.

قدرت حافظه منسجم

هماهنگی حافظه NVLink-C2C بهره وری، عملکرد و میزان حافظه قابل دسترسی GPU را افزایش می دهد. رشته های CPU و GPU می توانند به طور همزمان و شفاف به حافظه مقیم CPU و GPU دسترسی داشته باشند و به توسعه دهندگان این امکان را می دهد که به جای مدیریت صریح حافظه بر روی الگوریتم ها تمرکز کنند. هماهنگی حافظه به توسعه دهندگان اجازه می دهد فقط داده های مورد نیاز خود را انتقال دهند و کل صفحات را به و از GPU منتقل نکنند. همچنین با فعال کردن اتمی های بومی از هر دو CPU و GPU، همگام سازی های ابتدایی سبک وزن را در رشته های GPU و CPU فراهم می کند. نسل چهارم NVLink امکان دسترسی به حافظه همتا را با بارهای مستقیم، ذخیرهسازی و عملیات اتمی فراهم میکند، بنابراین برنامههای کاربردی سریعتر میتوانند مشکلات بزرگتری را راحتتر از همیشه حل کنند.